Een paar posts terug kwamen we de opkomende term big data tegen, die de gigantische hoeveelheid data beschrijft waar grote bedrijven naar kijken om er waarde uit te halen.

Voorbeelden van big data kun je vinden in de onvoorstelbare verzameling feiten, cijfers, beeld/video/multimedia data die de Google-zoekmachines hebben opgestapeld van 1997 tot nu, en in de enorme hoeveelheid persoonlijke en gerelateerde data die Facebook heeft verzameld van meer dan 1,35 miljard geregistreerde gebruikers wereldwijd sinds Mark Zuckerberg het in 2004 oprichtte. Andere organisaties hebben hun eigen sets big data uit hun eigen bronnen.

Alleen al het verzamelen van big data is een enorme klus die backend-ondersteuning vereist van datacenters die 24/7 het hele jaar door draaien – en de geavanceerde technologie in die datacenters. Met de extreem hoge kosten van het verzamelen van big data, is het alleen maar logisch dat het betrokken bedrijf die kosten wil terugverdienen door gebruik te maken van de Godzilla-achtige hoeveelheid data die in de opslagapparaten van het bedrijf ligt te wachten. Een belangrijke stap in het gebruik van big data is data-analyse, en ook dit vereist het gebruik van geavanceerde technologie.

Gelukkig bestaat zo’n technologie, dankzij hardware/software-leveranciers en open-source softwareontwikkelaars die komen met krachtigere verwerkingsmogelijkheden, hogere geheugenniveaus, vooruitgang in bandbreedte, en zeer gedistribueerde architecturen die opgewassen zijn tegen de uitdaging van big data.

Een specifieke technologie die eruit springt tussen de vele aanbiedingen op de markt is Apache Hive, die de Apache Software Foundation zelf omschrijft als “een data warehouse software (die) het bevragen en beheren van grote datasets in gedistribueerde opslag vergemakkelijkt“.

Hive werkt niet alleen. Het is gebouwd bovenop – en werkt samen met – Apache Hadoop, een open-source software die gedistribueerde verwerking van grote subsets van big data mogelijk maakt over geclusterde computers met behulp van eenvoudige programmeermodellen. Hadoop is ontworpen voor schaalbaarheid; gebruikersorganisaties kunnen beginnen met enkele servermachines en opschalen naar honderden of duizenden, en elke machine is in staat tot lokale berekening en opslag. De Hadoop-softwarebibliotheek is ontworpen om fouten op te sporen en af te handelen op applicatieniveau. Dit betekent een zeer beschikbare service over geclusterde machines.

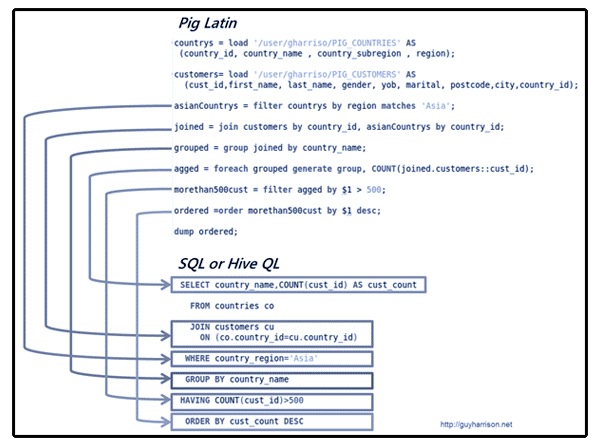

Hive heeft tools om gemakkelijk subsets van big data te extraheren, transformeren en laden die zijn opgeslagen in HDFS (Hadoop Distributed File System) of in andere compatibele opslagsystemen zoals Apache HBase. Het kan structuur opleggen aan verschillende dataformaten, waardoor het mogelijk wordt om het te bevragen met behulp van HiveQL (een querytaal die lijkt op SQL). Het vermogen om te bevragen biedt op zijn beurt de mogelijkheid om data te analyseren en er waarde uit te halen.

Data-queries op Hive worden uitgevoerd via Hadoop MapReduce, een softwareframework voor het eenvoudig schrijven van applicaties die multi-terabyte datasets parallel verwerken op clusters bestaande uit duizenden nodes. Reeksen van MapReduce-programma’s worden geproduceerd door een krachtig data-analyseplatform dat op de achtergrond werkt: Apache Pig. MapReduce en HDFS draaien in dezelfde set nodes.

Apache Hive en alle samenwerkende software hebben een geschikte IT-infrastructuur nodig om ze te huisvesten. Tenzij je het nodige talent in je bedrijf hebt, moet je gekwalificeerde IT-professionals raadplegen om je te helpen bij het plannen van de aanschaf en configuratie van de infrastructuur, omdat er veel technische details zijn waar aandacht aan moet worden besteed voordat Apache Hive big data-analyse in je bedrijf werkelijkheid kan maken.

Voor meer informatie, klik op deze links: Hive, Hadoop, MapReduce Tutorial, Apache Pig.

0 reacties